Jacques Pignault - Revue de l'ARA, mai 2025

Télécharger l'article sur le site de l'UARGA : Article

L’histoire de l’IA remonte aux années 1940, avec le mathématicien et logicien Alan Turing, souvent considéré comme le père de l’intelligence artificielle. Turing était convaincu que les machines pourraient être programmées pour reproduire l’intelligence humaine.

Au cours des années 1950 et 1960, l’intelligence artificielle a connu un développement rapide. Les chercheurs ont commencé à créer des programmes capables de résoudre des problèmes et de jouer à des jeux tels que les échecs. Les premiers programmes d’IA étaient relativement faibles et faisaient des erreurs, mais ils ont ouvert la voie à des avancées majeures.

L’un des moments les plus mémorables de cette période a été lorsque l’ordinateur Deep Blue d’IBM a battu le champion du monde d’échecs Garry Kasparov en 1997. C’était un succès monumental qui a prouvé que les machines pouvaient battre les humains dans des tâches complexes.

Dès le début des années 2000, l’IA a commencé à se transformer grâce à des algorithmes plus profonds et à des capacités de calcul accrues. L’IA est maintenant omniprésente dans notre vie quotidienne.

L’intelligence artificielle est un domaine en constante évolution, façonné par des décennies de recherche, de développement et de défis. De Turing aux algorithmes profonds d’aujourd’hui, elle a parcouru un long chemin, passant des machines logiques simples aux algorithmes profonds et aux systèmes d’apprentissage automatique d’aujourd’hui.

Qu’est-ce-que l’intelligence artificielle aujourd’hui et en quoi se démarque-t-elle de la traditionnelle programmation classique que nous connaissons tous ?

Un programme consiste à donner à une machine une série d’instructions à exécuter pour réaliser une tâche voulue, par exemple faire se déplacer un robot dans un environnement industriel donné. Le programme précise comment faire chaque étape (avancer, tourner…). Si l’environnement change et que le programme ne l’a pas pris en compte, la tâche ne peut s’accomplir. L’IA permet de s’affranchir notablement de cette sensibilité au changement en ne précisant pas le comment mais en donnant des méthodes d’adaptation pour réaliser la tâche voulue. Ces méthodes utilisent principalement les statistiques, qui donnent à la machine une capacité d’apprentissage, en se basant sur une modélisation de la situation.

Les applications d’analyse de textes par exemple utilisent à la fois les règles grammaticales (logique formelle) et les retours statistiques (apprentissage) sur de très grandes bases de données de textes. Il y a là deux logiques :

1- reconnaître les mots et les définitions d’après des mots clés qui les entourent, afin d’avoir la meilleure probabilité de bonne définition ;

2- chercher dans la « littérature » quels sont les mots ou groupes de mots qui, statistiquement, suivent le mieux le mot écrit.

Contrairement à des modèles de programmation obtenus à partir de méthodes déterministes, les logiques IA font ainsi appel à des méthodes statistiques entachant les résultats de probabilités d’erreurs.

L’intelligence artificielle s’attache à simuler l’intelligence humaine et ses capacités de résolution de problème. Elle utilise pour ce faire des réseaux neuronaux artificiels calqués sur la structure du cerveau humain. Ils permettent de démultiplier la puissance d’acquisition, d’analyse et de prise de décision d’un cerveau humain sans toutefois lui ressembler puisqu’ils sont dépourvus d’émotions et qu’ils recherchent à chaque fois, dans les données statistiques,

la meilleure probabilité. Certains ont pu avancer de façon imagée qu’ils sont aux cerveaux humains ce que les ailes des avions sont à celles des oiseaux !

Situés au carrefour de l’informatique et de la biologie, un réseau neuronal artificiel permet, de la même façon que celui de nos cerveaux (une couche d’entrée, une ou plusieurs couches cachées et une couche de sortie), de reconnaître, de trier et de classifier des jeux de données (images, sons, caractères, chiffres…) acquis via les capteurs qui lui sont raccordés.

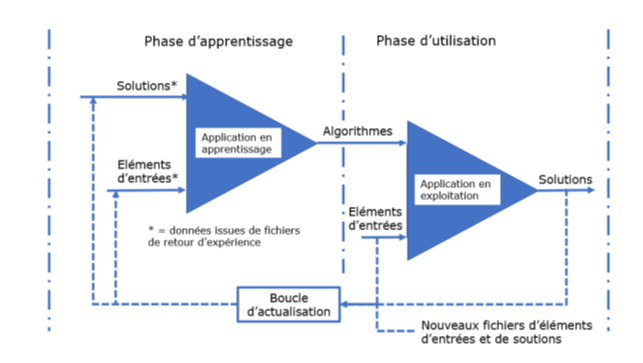

Spécialisée ou pas dans un domaine particulier, toute application d’intelligence artificielle passe par une phase d’apprentissage préalable à son utilisation. La figure 1 présente les deux phases (« apprentissage » et « utilisation ») du cycle de vie d’une application IA.

Figure 1 : phases de vie d’une application IA (source : Fascinante IA, J. Pignault, Jean Magne, Boleine 2019)

L’objectif de la phase d’apprentissage est de permettre aux réseaux neuronaux de l’application d'identifier des modèles complexes et de prendre des décisions basées sur les données qu’ils captent. Pour ce faire, le concepteur nourrit l’application de données issues de fichiers de retour d’expérience (éléments d’entrées et solutions en résultant) pour que les réseaux neuronaux de l’application élaborent des modèles.

Il est important de noter que l’obtention d’un modèle fiable nécessite l’utilisation d’un très grand nombre de données et donc des capacités mémoires informatiques très importantes.

Que ce soit dans les IA de reconnaissance d’images, d’apprentissage du langage et autres, le fait d’avoir besoin de nombreuses données d’apprentissage montre que le système a besoin de ce grand nombre pour rechercher la plus grande probabilité d’être proche de la vérité :

Reconnaissance faciale : probabilité que les formes modélisées correspondent à la morphologie d’une personne donnée. Reconnaissance d’image : probabilité pour chaque neurone d’approcher une des caractéristiques de l’objet à reconnaître. Langage : probabilité que le mot corresponde à telle définition d’après le contexte, puis que le mot qui suit présente la meilleure statistique dans le langage parlé.

De suite, on perçoit les limites du système : si une personne malveillante introduit des données fantaisistes, la machine apprendra des erreurs (on appelle cet acte malveillant l’empoisonnement de l’IA). De même, la banque de données fournies est sélectionnée par les concepteurs et quand ceux-ci ont des biais, cela se retrouve dans le « raisonnement » de la machine.

Un exemple pédagogique souvent utilisé est celui du chat : les éléments d’entrée sont des photos de chats, les solutions sont la reconnaissance d’un chat. Les neurones artificiels des couches du réseau aboutissent à un modèle de chat en opérant des tris et classifications des informations présentées (couleurs, formes, agencements d’ensembles, …). En revanche, si on propose à la machine une photo de chat peint en vert, elle peut ne pas reconnaître l’animal et proposer une autre solution. Cette forme de « leurrage » de l’IA est identifiée et consiste à proposer un cas non conforme qui n’est pas entré dans le modèle.

Les modèles requis pour l’application ayant été obtenus, il s’agit de les valider. Pour cela de nouvelles données sont introduites et le concepteur vérifie la pertinence des réponses de l’application. Dans l’exemple précédent pris, le concepteur présentera des photos de différents animaux et vérifiera la pertinence des réponses de l’IA.

L’application entre en phase d’utilisation après avoir été validée. Toute nouvelle utilisation, qu’elle soit satisfaisante ou pas (la solution proposée par l’IA n’est pas la bonne, la modélisation est donc mise en échec) doit être introduite dans la boucle d’apprentissage afin d’être prise en compte pour affiner ou corriger les poids respectifs des neurones des couches des réseaux.

Ainsi définie, l’IA entre bien dans la lignée des outils développés par l’Homme pour prolonger ses capacités physiques et intellectuelles :

• Mieux faire (plus vite, moins cher, plus adapté) ce qu’il peut faire,

• Faire ce qu’il ne sait (ou ne peut) pas faire

Il faut bien souligner que le domaine privilégié des applications de l’Intelligence Artificielle (IA) est la résolution de problèmes à solutions probabilistes (solutions vraisemblables à des niveaux de confiance variables, la météo par exemple). Les résultats obtenus correspondent alors aux solutions les plus vraisemblables et une interprétation est nécessaire. En revanche, lorsque la résolution est de type déterministe (problèmes à solution unique, automatismes de sécurité d’une installation industrielle par exemple), point n’est besoin d’IA, de logique floue (association à toute proposition logique d’un certain degré de certitude ou d’incertitude modulant les assertions vrai ou faux) et d’apprentissage profond. Ils restent du ressort des algorithmiques « classiques » (par exemple, si la pression excède un seuil donné, ouvrir la soupape de sécurité).

L’IA est souvent considérée comme le moyen de créer un Homme “augmenté”, c’est-à-dire : libéré, démultiplié, complété. C’est dans cet esprit qu’elle se développe dans de nombreux secteurs : habitat, transport, médecine, sport, mondes militaire, scientifique et industriel, commercial et administratif. Une restriction importante apparaît toutefois dans son utilisation : la traçabilité des décisions prises par les applications IA n’est souvent pas assurée (modèles de type « boîte noire ») et il est difficile de garantir leur pertinence. Là est la raison principale pour laquelle les application IA en contrôle-commande de processus sont sujettes à circonspection.

Dans l’industrie nucléaire par exemple, l’utilisation de modélisations IA (apprentissage automatique par exemple) conduit à des améliorations sensibles notamment dans les domaines de la maintenance prédictive et de la surveillance de site. L’AIEA (Nelly Ngoy Kubelwa, ingénieure nucléaire spécialisée dans les technologies innovantes) considère « qu’associée à d’autres technologies, comme les jumeaux numériques, l’IA pourrait considérablement accroître l’efficacité de la production d’énergie d’origine nucléaire ». Pour l’heure, l’opacité avec laquelle les réseaux de neurones artificiels fonctionnent et parviennent à des conclusions constitue un frein pour une utilisation plus large de l’IA.

Les applications IA opérationnelles, en développement ou simplement espérées ont des niveaux « d’intelligence » et des domaines d’application différents. L’usage est de les regrouper en trois types (Source site IA-INSIGHTS) :

• IA Faible (ou IA étroite)

Elle est spécialisée dans une seule tâche ou un petit ensemble de tâches. Elle n’a pas la capacité de penser ou de raisonner en dehors de son domaine de spécialisation. Les exemples courants d’IA faible incluent les assistants vocaux tels que Siri et Alexa, les systèmes de recommandation tels Netflix ou Spotify, les applications de reconnaissance d’image tels Face ID sur les iPhones ou les systèmes de navigation tels Google Maps.

• IA Générale (ou IA forte)

Elle possède la capacité de « raisonner », d’apprendre et de résoudre des problèmes dans n’importe quel domaine, tout comme un être humain. Une grande partie des applications visées n’existent pas encore sous une forme pleinement fonctionnelle. Parmi les applications en opération ou en développement, on peut citer la reconnaissance d’images et de vidéos, la traduction automatique, les véhicules autonomes, l’analyse de données médicales, la génération de texte.

Cette dernière application est la cause d’une littérature abondante sur la façon dont elle « comprend » et répond aux questions. En effet, la façon dont d’une part, elle interprète les mots par rapport au contexte afin d’établir un sens à la question et, d’autre part, la façon dont elle recherche les mots les plus probables qui suivent une suite de caractères posent question. Il convient de bien comprendre le principe de fonctionnement des LLM (Large Language Machine) pour tirer le meilleur profit de leurs performances, et donc, bien cadrer la question et préciser où chercher les réponses.

• Super intelligence artificielle (ASI)

L’IA super intelligente est un concept futuriste où les machines surpasseraient les humains dans la plupart des activités économiquement et intellectuellement exigeantes. Cette forme d’IA serait capable d’améliorer ses propres capacités de manière autonome et de résoudre des problèmes complexes qui dépassent la capacité humaine.

À l’heure actuelle, l’IA super-intelligente reste un concept théorique et n’existe pas dans la réalité. Cependant, on peut imaginer ce qu’elle serait et comment elle pourrait être utilisée si elle était réalisée. L’exploration spatiale ou la résolution de problèmes mondiaux complexes tels que le changement climatique constituent quelques exemples hypothétiques.

Sur les plans économique et scientifique, les effets des développements réalisés, en cours ou à venir sont très positifs. Il est clair néanmoins que se dressent de redoutables écueils à consonance humaine qui concernent nos vies :

• professionnelles (pertes d’emplois ou emplois sous contrôle d’un robot, suppression du dialogue et des échanges entre pairs, entre métiers, entre collaborateurs d’une même entreprise) ;

• personnelles (pertes d’autonomie car assistance totale dans la vie courante, pertes des

• libertés par suivi permanent, délaissement du lien social réel pour le lien social virtuel) ;

• familiales (transmission des valeurs, solidarités familiales) ;

• spirituelles (perte de la place et du projet de l’homme dans l’univers, perte de sens dans l’activité et le lien social) .

Contourner ces écueils nécessite principalement la mise en place de programmes de formations initiales et permanentes permettant aux hommes de suivre et de dominer l’évolution de ce puissant outil qu’est l’IA. Par exemple, apprendre à superviser le fonctionnement d’un robot IA au lieu de faire directement les tâches qu’il accomplit. De tels programmes ne sont hélas aujourd’hui pas totalement au rendez-vous.

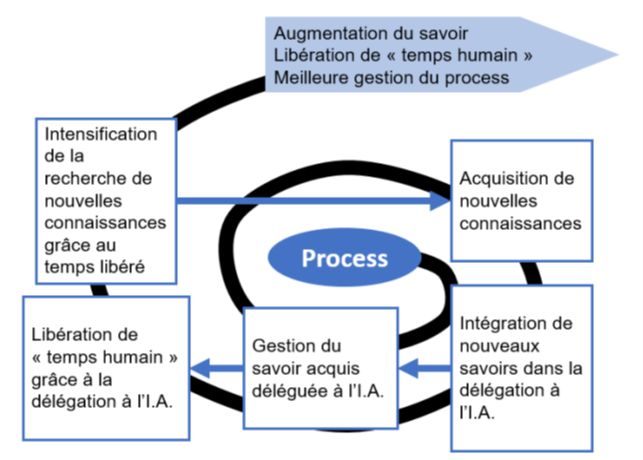

Dans l’hypothèse selon laquelle les développements visés aboutissent et les écueils principaux sont évités, l’IA va compléter, démultiplier et libérer l’Homme pour lui permettre de focaliser ses efforts sur la recherche et la découverte (cf. figure 2 « la spirale du progrès »).

Mais le fera-t-il ou cèdera-t-il à la facilité de ne rien faire ? L’intelligence artificielle nous amènerait-elle à ne plus penser ?

Figure 2 : la spirale du progrès (source : Fascinante IA, J. Pignault, Jean Magne, Boleine 2019)

Jacques Pignault est un expert reconnu en gestion des risques organisationnels, techniques et humains, avec une spécialisation dans l’instauration durable d’une culture de sécurité en entreprise. Ingénieur et docteur ès Sciences, il possède une expérience de plus de 35 ans dans le domaine, dont 18 années en conseil et 17 années en ingénierie, notamment dans les grands projets nucléaires.

Il est co-auteur des livres Fascinante IA avec Bertrand Foy et Jean Magne (Boleine, 2021) et de Prendre la bonne décision, anticiper et réduire les risques avec Jean Magne (Boleine, 2022).

Retrouver une interview de l’auteur de l'article sur Youtube en cliquant ici.